Destina Karadas

•4 Juni 2025

Generative KI im Personalauswahlprozess: Revolution oder Risiko?

Künstliche Intelligenz (generative KI) begegnet uns heutzutage überall. Auch in der Personalauswahl werden Organisationen zunehmend mit der Nutzung von KI konfrontiert, sowohl von Seiten der Bewerber*innen als auch bei der Durchführung ihrer Assessments.

Während einige Arbeitgeber*innen die Nutzung von KI als Gefahr sehen, da unbeaufsichtigte Tests mit Kandidat*innen ihre Wirksamkeit verlieren können, bietet KI z.B. auch die Möglichkeit, Testinstruktionen zu übersetzen und so Sprachbarrieren abzubauen.

Der Frage nach den positiven und negativen Konsequenzen von generativer KI-Nutzung im Auswahl- und Arbeitskontext haben sich auch Lievens und Dunlop (2024) in ihrem Artikel “Effects of Applicants’ Use of Generative AI in Personnel Selection: Towards a More Nuanced View?” gewidmet. Die Ergebnisse ihrer Untersuchung stellen wir hier einmal vor.

Generative KI – Was ist das und wie wird sie genutzt?

Generative Künstliche Intelligenz (KI) bezeichnet Systeme, die selbstständig Inhalte wie Texte, Audios oder Grafiken erzeugen können. Die bekannteste KI “GPT”, ein sogenanntes LLM – “Large Language Model”, wird seit 2022 immer verbreiteter und relevanter, auch im Arbeitskontext.

Im Kontext von Assessments kann KI die Bewerber*innen unterstützen, etwa beim Erstellen eines Anschreibens oder Beantworten von Fragen in einem verbalen Test zum logischen Schlussfolgern. Studien zufolge schneiden KI-Antworten dabei besser ab als mindestens 94% der menschlichen Testteilnehmer*innen (Hickman et al., 2024). Auch in den oft eingesetzten Situational Judgment Tests führt der Einsatz von KI häufig zu höheren Testwerten (Borchert et al., 2023). Gleichzeitig zeichnen sich KI-generierte Antworten oft jedoch durch wiederkehrende, charakteristische Formulierungen aus, die wenig kreative Vielfalt in Texte (z.B. Anschreiben) bringen, sodass Kandidat*innen immer eigens überprüfen sollten, was sie von KI-Antworten übernehmen.

Wie bereits erwähnt kann die Validität von unbeaufsichtigten Assessments durch die KI-Nutzung eingeschränkt werden, weshalb sich einige Anbieter*innen schützen, indem sie zusätzlich Daten auswerten, die während der Tests von den Kandidat*innen produziert werden (z.B. Mausbewegungen) oder Algorithmen einsetzen, um KI-generierte Texte zu identifizieren.

Doch welche tatsächlichen Effekte hat der Einsatz von KI auf die Validität der Assessments?

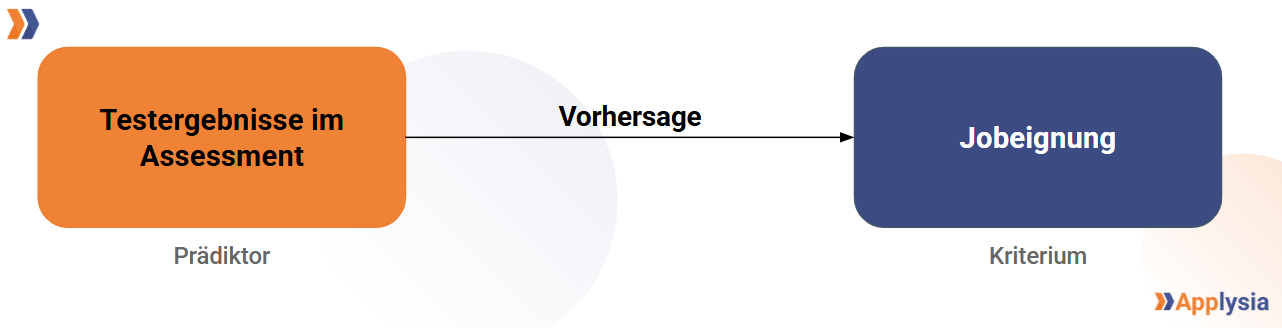

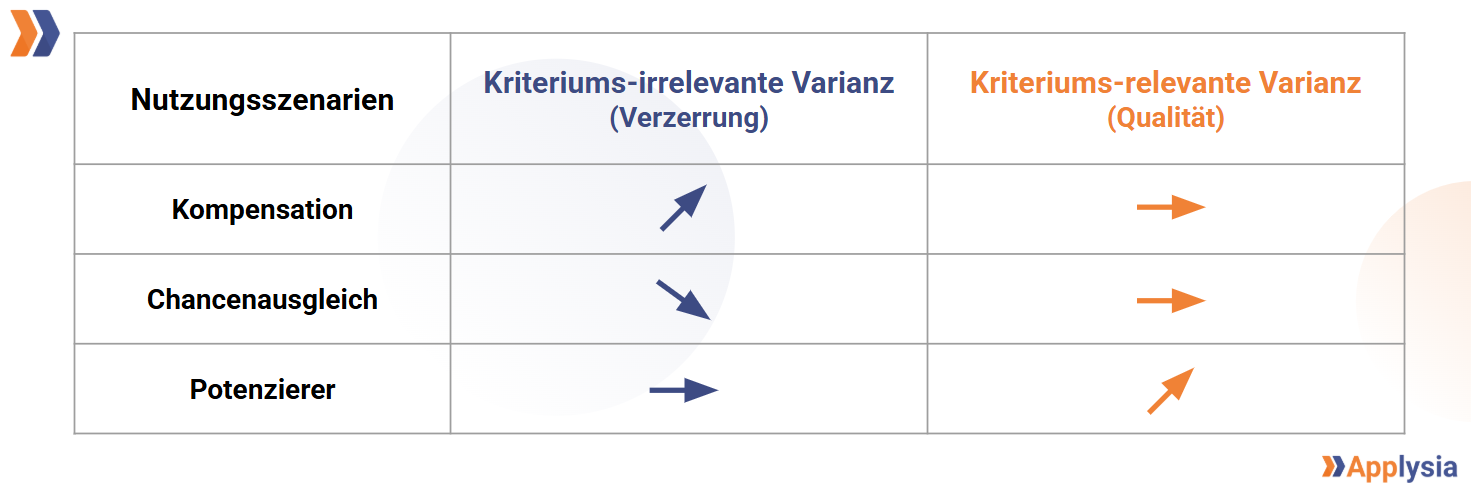

Zur Beantwortung dieser Frage unterscheiden Lievens und Dunlop drei Szenarien, in denen generative KI auf unterschiedliche Weise genutzt wird, mit jeweils unterschiedlichen Konsequenzen für die “kriteriums-irrelevante Varianz” (KIV) oder die “kriteriums-relevante Varianz” (KRV) . Die Varianz zeigt, wie stark die Testergebnisse der Kandidat*innen um ihren Durchschnittswert schwanken, wobei Assessments zur Messung der Eignung einer Person für einen Job verwendet werden. Diese Variable nennt man das Kriterium.

Die KIV kann die Zuverlässigkeit des Assessments negativ beeinflussen, indem sie externe Faktoren misst, die nichts mit der Eignung eines/einer Kandidat*in zu tun haben.

Die KRV hingegen reflektiert und misst die tatsächlichen Unterschiede in den Fähigkeiten von Personen und ist damit von großer Bedeutung, um valide Vorhersagen mithilfe der Testergebnisse treffen zu können.

Folgende drei Szenarien werden unterschieden:

1. KI-Nutzung erhöht KIV – generative KI zur “Kompensation”

In diesem Fall nutzen Kandidat*innen KI, um ihre Wissenslücken oder mangelnde Verhaltenskompetenzen vollständig auszugleichen, indem sie KI-Outputs eins zu eins in ihre Antworten und Lebensläufe übernehmen. Folglich spiegeln die Testergebnisse nicht die wahren Eigenschaften der Person wider. Dies führt zu besseren Testergebnissen für den/die Kandidat*in, aber zu einer geringeren Validität des Assessments, was suboptimale Personalauswahl in Unternehmen zur Folge haben könnte.

2. KI-Nutzung reduziert KIV – generative KI zum “Chancenausgleich”

Positive Auswirkungen durch den Einsatz von KI können sich ergeben, wenn dadurch Prüfungsangst, Unerfahrenheit oder Sprachbarrieren überwunden werden. In diesen Fällen können dann die wahren Ausprägungen einer Person gemessen werden, was zu einer höheren Validität des Assessments führt. Die KI kann z.B. für die Simulation einer Prüfungssituation genutzt werden. Diese Übung könnte dazu führen, dass sich Personen mit Prüfungsangst in Prüfungssituationen (z.B. einem Interview) sicherer fühlen und besser ausdrücken können. Die Testergebnisse dieser Person spiegeln dann also nicht ihre Ängstlichkeit wider, sondern ihre job-relevanten Kompetenzen. Dies könnte einen wichtigen Beitrag zu fairen und gleichberechtigten Auswahlprozessen für Menschen mit Benachteiligungen darstellen und den Person-Job-Fit erhöhen, woraus sich auch Vorteile für Arbeitgeber*innen ergeben.

3. KI-Nutzung erhöht KRV – generative KI als “Potenzierer”

KI hat die Fähigkeit, einerseits die Stärken von Individuen im Auswahlprozess hervorzuheben und gleichzeitig die Schwächen einer Person auszugleichen.

Der Nutzen geht jedoch über die Phase des Assessments hinaus. Je nach Möglichkeiten, die Arbeitnehmer*innen gegeben werden, die KI auch im Job zu nutzen, kann die Verwendung im Bewerbungsprozess wertvolle Aufschlüsse über die Leistung und Effizienz am Arbeitsplatz geben. Bezogen auf die Aufgabenleistung lassen sich recht genaue Vorhersagen treffen, unklar ist jedoch noch, wie nachhaltig die Verbesserungen durch KI sind. Hierbei ist zwischen einmaliger Leistungssteigerung und tiefgehendem Lernen zu unterscheiden.

Alle drei Szenarien führen zu besseren Testergebnissen der Kandidat*innen im Assessment, aber je nach Verwendung der KI lassen sich unterschiedliche Konsequenzen für die Validität des Assessments beobachten.

Folgende Grafik fasst diese Erkenntnisse noch einmal zusammen:

Für Organisationen empfiehlt sich folgender Umgang damit bei ihren Assessment Centern:

- Zunächst sollte der Aufbau des Assessments mit allen angewandten Methoden auf die Sensibilität für den Einsatz von KI überprüft werden. Falls die KI die Darstellung der wahren Kompetenzen einer Person in einem Test oder Interview verzerrt, indem z.B. sozial erwünschte Antworten künstlich generiert werden, sollte das Assessment angepasst werden. Dies kann durch interaktive und komplexere Assessments (z.B. umfassende Videoantworten) oder Software, die den Einsatz von KI erkennt, umgesetzt werden. Tests, die besonders anfällig für solche Verzerrungen sind (z.B. Tests zur sprachlichen Eignung bzw. unbeobachtete Testdurchführungen) sollten, wenn möglich, vom Assessment ausgeschlossen werden.

- Durch die fortlaufende Verbesserung von KI ist es wichtig, ebenfalls ständige Kontrollen und Weiterentwicklung von Seiten der Organisationen sicherzustellen. Ein nachhaltiger Ansatz ist eine mehrseitige Überprüfung der Kandidat*innen-Antworten (z.B. die Nutzung von mündlichen Kandidat*innen-Antworten oder interaktiven Daten), die sogenannte Multimethodalität. Mithilfe derer können die gesammelten Daten mit höherer Sicherheit die tatsächliche Eignung eines/einer Kandidat*in für einen Job widerspiegeln, da das Ergebnis nicht nur auf einer Datenquelle basiert, die möglicherweise durch den Einfluss von KI verzerrt ist.

- Ein weiterer Tipp ist die Aufklärung der Bewerber*innen über den erlaubten Einsatz von KI und die Einschränkungen während des gesamten Auswahlprozesses. Klare Vorgaben fördern die Ehrlichkeit und Transparenz von Seiten der Bewerber*innen für Selbstauskünfte in ihren Lebensläufen, Anschreiben, etc.

- Falls der Einsatz von KI auch am späteren Arbeitsplatz erlaubt oder sogar erwünscht ist, lohnt es sich, den effektiven Umgang von Bewerber*innen mit KI im Auswahlprozess als Variable zu betrachten. Relevant könnten hier z.B. die Effizienz und Transparenz sein, mit der die Person den Einsatz von KI zur Problemlösung in Situational Judgment Tests angibt.

Wie oben geschildert, wird der Einfluss von künstlicher Intelligenz im Personalauswahl-Kontext und für Assessments immer größer, weshalb wir bei Applysia zunehmend KI in unsere Software integrieren. Eine Beispielfunktion stellen unsere KI-basierten Platzhalter für den Ergebnisbericht dar. Dabei ist uns wichtig, dass die Bewertungen der Beobachter*innen, anhand derer Entscheidungen über die Kandidat*innen getroffen werden, weiterhin auf menschlichem Denken basieren. Die KI schreibt in unserer Software lediglich eine Zusammenfassung aus den Beurteilungen und Notizen der Beobachter*innen.

Wir setzen uns dafür ein, Fairness, Transparenz und Effizienz in der Personalauswahl sicherzustellen und unterstützen euch dabei, KI für diese Zwecke optimal zu nutzen. Weitere Informationen zu digitalen Assessments und Applysia findet ihr unter www.applysia.de. Wenn ihr mehr zum Thema KI bei Applysia erfahren wollt, meldet euch bei uns!