Mit den Applysia Insights ermöglichen wir Einblicke in Ihre Assessment-Prozesse ohne langwieriges Sammeln und Auswerten von Daten. Dabei fokussieren wir uns zunächst vor allem auf die Evaluation des Prozesses und der bereits abgeschlossenen Assessments, denn genauso wichtig wie die sorgfältige Konzeption eines Assessment Centers ist die regelmäßige Evaluation dieser. Laut DIN 33430 sollte etwa alle acht Jahre eine Evaluation der Prozesse in der Personalauswahl stattfinden. Gleichzeitig ist so eine Evaluation der Prozesse allerdings oftmals sehr aufwändig und wird deshalb selten durchgeführt. Daher haben wir mit den Applysia Insights eine nutzerfreundliche, intuitive und innovative Lösung entwickelt, um einfache und effiziente Prozessverbesserungen zu ermöglichen.

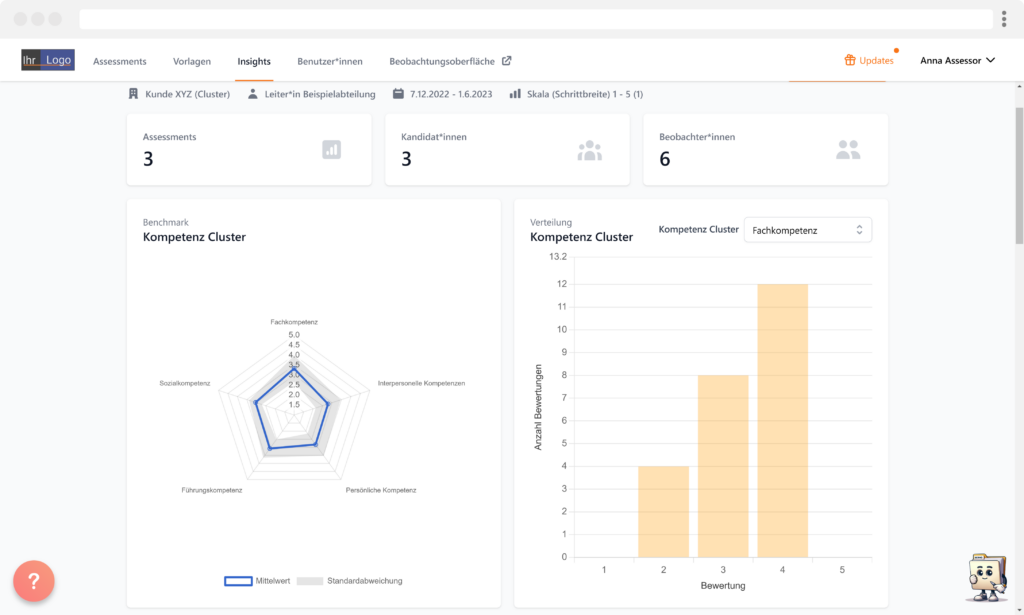

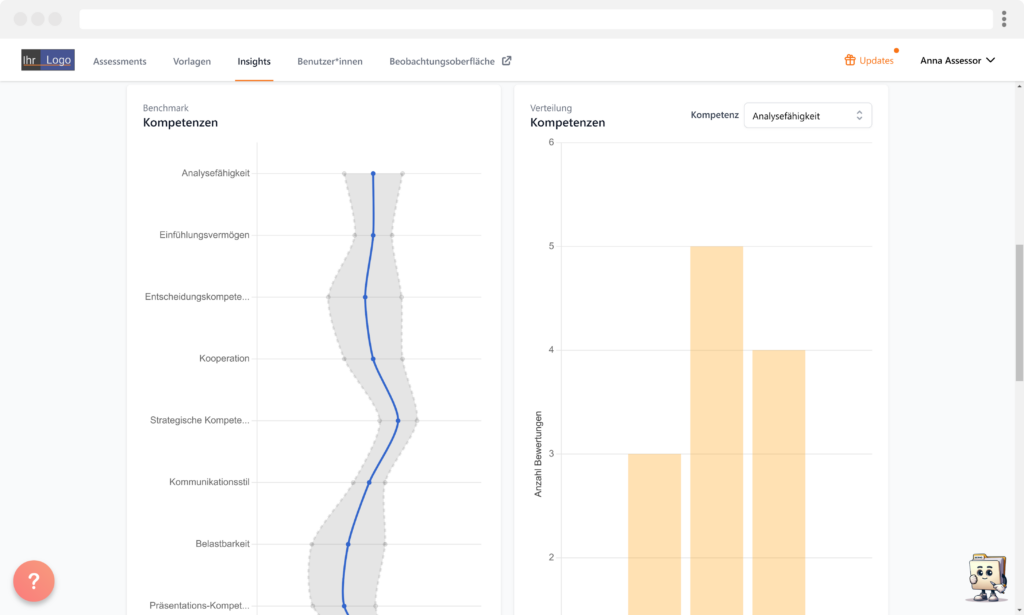

Benchmarks

Die Benchmarks bilden die Grundlage der Insights. Es stehen sowohl Benchmarks für die Kompetenz Cluster als auch für die einzelnen Kompetenzen zur Verfügung.

Mit Hilfe von Charts wird angezeigt, wie die einzelnen Kompetenzen und die Kompetenz Cluster im Mittel bewertet wurden. Oder in anderen Worten: Das Kompetenzprofil der*s Durchschnitts-Kandidat*in. Gleichzeitig wird auch die Standardabweichung der Bewertungen abgebildet, um die Streuung der Werte zu visualisieren. Die Streuung gibt also an, ob der Mittelwert dadurch zu Stande kommt, dass alle Kandidat*innen immer die gleiche Bewertung erhalten oder ob die Bewertungen sehr unterschiedlich sind.

Zusätzlich werden die Verteilung und die genaue Anzahl der Bewertungen einer ausgewählten Kompetenz angezeigt. Die Anzahl der Bewertungen stimmt nicht zwangsläufig mit den Beobachter*innen überein, da die einzelnen Kompetenzen eines Clusters in einem Assessment auch in mehreren Übungen bewertet werden können.

Die Werte dieser Benchmarks ermöglichen spannende Einsichten. So können bei der Beurteilung zukünftiger Kandidat*innen die Benchmarks herangezogen werden, um einschätzen zu können, wie diese im Vergleich zu anderen Kandidat*innen abgeschnitten haben. Diese Beurteilung ist wichtig, da es durchaus sein könnte, dass alle Kandidat*innen in einer Kompetenz auf einer Skala von eins bis fünf im Schnitt mit einer 1,5 bewertet wurden. Haben Sie nun eine*n Kandidat*in mit der Bewertung von 2,5 vor sich, so liegt diese Bewertung zwar genau in der Mitte der Skala, aber ist im Vergleich zu der mittleren Bewertung der vorherigen Kandidat*innen schon eine überdurchschnittliche Ausprägung dieser Kompetenz.

Gleichzeitig schließt sich auch fast automatisch die Reflexion des Kompetenzmodells an. Möglicherweise war es nicht beabsichtigt, dass alle Kandidat*innen so “niedrig” abschneiden und die Übung könnte angepasst werden. Dabei ist auch die Betrachtung der Standardabweichung interessant. Ist diese sehr gering, spricht das dafür, dass alle Kandidat*innen immer dieselbe Bewertung erhalten. Dies ist vor allem in Personalauswahlprozessen nur selten wünschenswert, da es ja um die Auswahl von Kandidat*innen aus einer größeren Gruppe geht und es dabei vor allem wichtig ist, die Unterschiede der Kandidat*innen zu ermitteln.

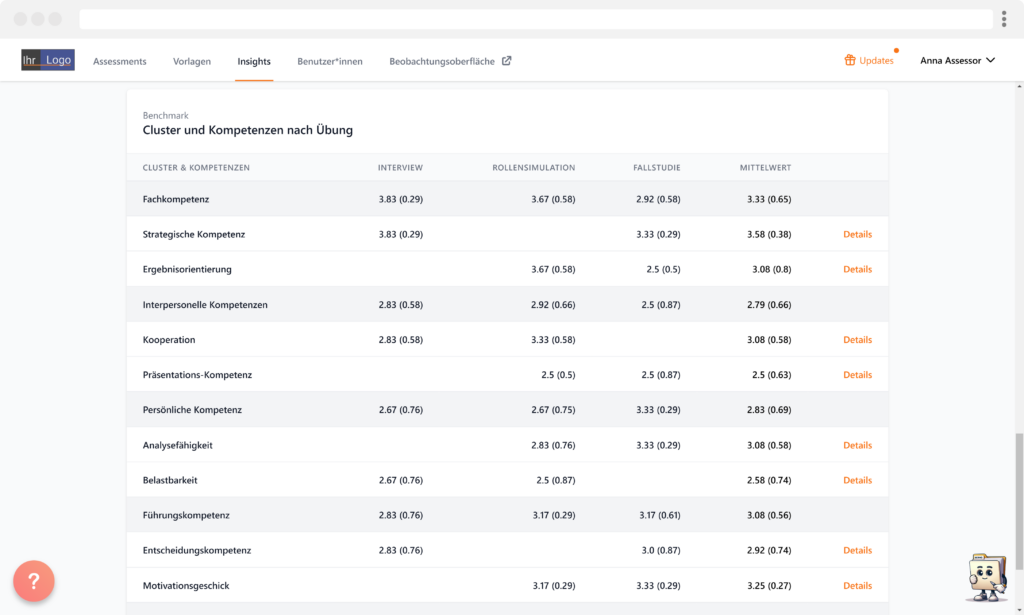

Cluster und Kompetenzen nach Übung

Außerdem wird eine Tabelle mit den Mittelwerten (Standardabweichungen in Klammern dahinter) aller Kompetenz Cluster und aller einzelnen Kompetenzen in verschiedenen Übungen angezeigt.

Details

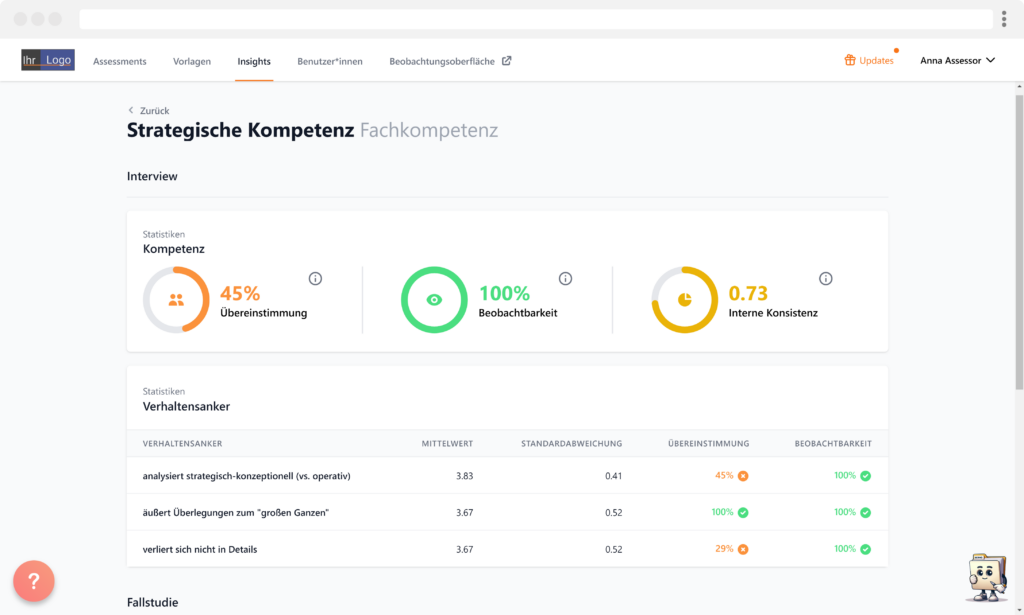

Für die einzelnen Kompetenzen stehen auf Kompetenz- und auf Verhaltensanker-Ebene verschiedene Statistiken bereit. Die einzelnen Kennwerte werden farblich markiert, um die Interpretation der Ergebnisse zu erleichtern.

Beobachter*innen-Übereinstimmung

In den Applysia-Insights wird automatisch die Beobachter*innen-Übereinstimmung berechnet (für alle Statistiker*innen: die Intraklassen-Korrelation) – sowohl für die Bewertungen aller Kompetenzen als auch für die Bewertungen der Verhaltensanker.

Die Übereinstimmung ist somit ein Maß dafür, inwieweit sich die Bewertungen verschiedener Beobachter*innen, z.B. bei einem Verhaltensanker, decken. Dabei werden die Unterschiede über Kandidat*innen hinweg gemittelt, um sicherzustellen, dass nur allgemeine Tendenzen und nicht individuelle Profile die Daten beeinflussen. Hat ein Anker also z.B. eine sehr geringe Übereinstimmung, könnte das ein Hinweis darauf sein, dass dieser nicht eindeutig genug formuliert ist und so bei den Beobachter*innen zu Missverständnissen führt, was genau bewertet werden soll. So kann es dann passieren, dass Beobachter*innen sehr verschiedene Bewertungen abgeben, obwohl sie die/den Kandidat*in gleichzeitig beobachtet haben. Hier ist eine möglichst hohe Ausprägung wünschenswert.

Kurz gesagt: Wie hoch ist das Agreement (der Bewertungen) der verschiedenen Beobachter*innen?

Beobachtbarkeit

Die Beobachtbarkeit gibt Aufschluss darüber, ob eine Kompetenz oder ein Verhaltensanker in einer Übung überhaupt beobachtet werden kann. Wenn z.B. die Hälfte aller Beobachter*innen einen Verhaltensanker in einer Übung nicht bewertet, könnte das dafür sprechen, dass dieser Verhaltensanker in dieser Übung oft einfach nicht (eindeutig) beobachtet werden kann. Dies ist dann ein guter Ansatzpunkt, um die Gestaltung der Übungen gezielt zu evaluieren, bei Bedarf zu überarbeiten und so dann die gewünschten Kompetenzen (eindeutig) zu beurteilen. Hier sollte also eine möglichst 100%ige Ausprägung das Ziel sein.

Kurz gesagt: Wurden alle Kompetenzen und Verhaltensanker von allen Beobachter*innen bewertet?

Interne Konsistenz

Die interne Konsistenz (für alle Statistiker*innen: hier Cronbach’s Alpha) hilft dabei zu beurteilen, inwieweit die Verhaltensanker dazu geeignet sind, eine zusammenhängende Kompetenz einzuschätzen. Ein hoher Wert bedeutet, dass die Anker stark miteinander zusammenhängen und somit wahrscheinlich zur Einschätzung derselben Kompetenz geeignet sind. Ist der Wert niedrig, passt vermutlich mindestens einer der Anker nicht zu den anderen. Dies kann insbesondere bei recht breiten Kompetenz-Klassen und “kombinierten” Kompetenzen wie z.B. “Strategie- und Handlungskompetenz” der Fall sein. Grundsätzlich heißen hier niedrigere Werte nicht, dass die Verhaltensanker “schlecht” sind, sondern vielmehr sollte man hier dann genauer hinsehen, denn es könnte durchaus Sinn ergeben, die Kompetenz aufzuteilen.

Kurz gesagt: Passen die einzelnen Verhaltensanker zusammen und messen sie dieselbe Kompetenz?

Euer Wunsch-Feature ist dabei, ihr seid absolut begeistert, aber noch keine Applysia-User*innen?

Dann meldet Euch gerne bei uns und wir vereinbaren eine kostenlose und unverbindliche Demo, in der wir Euch zeigen, wie unsere Software genau funktioniert und welchen Mehrwert Applysia für Euren Personal-Prozess bietet. Außerdem beantworten wir gerne all Eure Fragen. Wir freuen uns drauf 🚀