Emily Klöber

•10 September 2024

Mehr sprechen, weniger testen! Warum Interviews bei der Personalauswahl an Bedeutung gewinnen.

Noch besser, noch einfacher, noch präziser. Der Traum eines jeden HR-Profis ist ein fehlerfreier Test, der exakt das misst, was er messen soll, und dabei eine hohe Vorhersagekraft aufweist. Doch dieser Anspruch bleibt eine Utopie, was oft zu Frustration führt – es sei denn, man biegt die Realität ein wenig zurecht. Eine provokante Interpretation der Studienergebnisse von Schmidt und Hunter (1998) im Licht der aktuellen Revision von Sackett et al. (2021) könnte genau das nahelegen.

Die Metaanalyse von Schmidt und Hunter (1998) gilt seit jeher als Goldstandard zur Bewertung der Validität von Personalauswahlinstrumenten. Seit ihrer Veröffentlichung haben HR-Expert*innen ihre Entscheidungsprozesse stark auf diese Ergebnisse gestützt. Doch eine aktuelle Analyse von Sackett und Kollegen (2021) hat wesentliche Abweichungen gefunden, die die Gültigkeit vieler verbreiteter HR-Instrumente infrage stellen könnten.

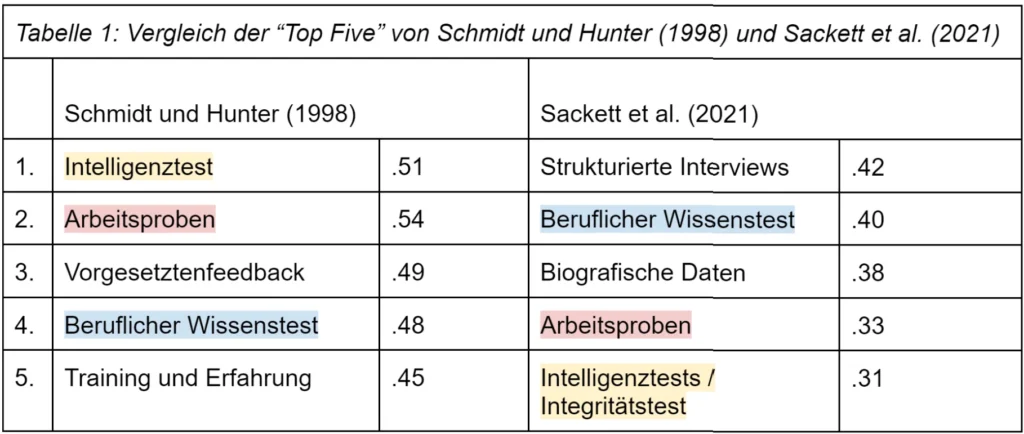

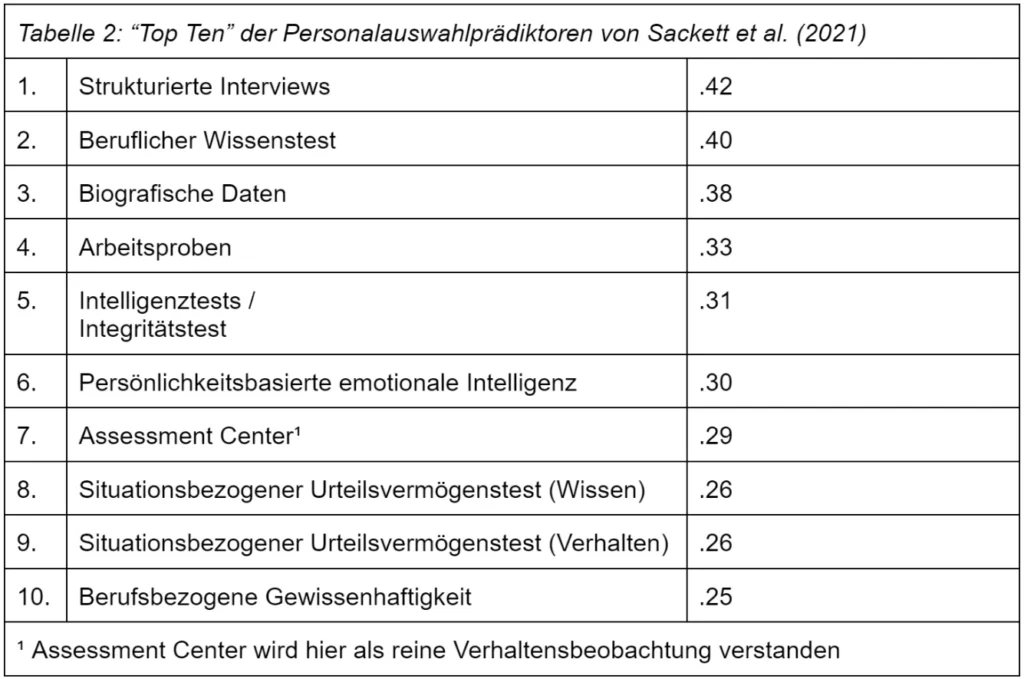

(Für einen schnellen Überblick haben wir unten zwei Tabellen zusammengestellt: Tabelle 1 vergleicht die Ergebnisse beider Studien, Tabelle 2 zeigt die „Top 10 Personalauswahlinstrumente“ von Sackett et al. (2021).)

Intelligenztests im Fokus: Ein Vergleich der Studien von Schmidt und Hunter (1998) und Sackett et al. (2021)

Schmidt und Hunter (1998) nutzten Intelligenztests als Grundlage zur Vorhersage von Berufserfolg und untersuchten, wie gut andere Methoden diesen zusätzlich prognostizieren können. Ihr zentrales Ergebnis: Intelligenz ist der beste Indikator für berufliche Leistung. Dementsprechend wurden Intelligenztests als wichtiges Auswahlinstrument empfohlen, und viele Kandidat*innen wurden basierend auf ihren Ergebnissen ausgewählt oder abgelehnt. Ein Update von Schmidt et al. (2016) bestätigte diese Aussage, stellte jedoch fest, dass die Validitäten der untersuchten Auswahlinstrumente deutlich höher lagen als ursprünglich angenommen.

Diese Unterschiede sind auf sogenannte „überkorrigierte Range Restrictions“ zurückzuführen – ein kompliziertes Thema, das im Wesentlichen darauf hinweist, dass kein Test fehlerfrei misst. Üblicherweise werden Fehleranteile in den Ergebnissen durch Korrekturen ausgeglichen, um möglichst präzise das zu messen, was im Fokus steht (z.B. Intelligenz). Range Restrictions bedeuten eine Einschränkung der Variabilität des Prädiktors (z.B. Intelligenz) und/oder des Kriteriums (z.B. Berufserfolg) – etwa durch Mindestanforderungen an die Intelligenz für eine Einstellung. Werden diese Korrekturen jedoch übertrieben, können die Ergebnisse künstlich aufgebläht und den Methoden zu hohe Korrelationswerte zugeschrieben werden. Dadurch erscheint die Vorhersagekraft eines Instruments größer, als sie tatsächlich ist.

Sackett und Kollegen (2021) haben die ursprüngliche Metaanalyse erneut untersucht und dabei die Überkorrekturen analysiert. Ihre Ergebnisse liefern vermutlich eine realistischere Einschätzung der Validität von Auswahlinstrumenten (siehe Tabelle 1).

Aus der Analyse lassen sich vier zentrale Erkenntnisse ableiten:

- Geringere Validitäten von Intelligenztests: Intelligenztests zeigen durchgehend geringere Validitäten als bisher angenommen. Sackett et al. (2021) sehen Intelligenztests zwar weiterhin als brauchbaren Prädiktor für Berufserfolg, jedoch mit deutlich niedrigeren Werten als Schmidt (2016) und Schmidt und Hunter (1998) (r = .51 vs. r = .31).

- Überschätzung der Intelligenztests: Der Erklärungsbeitrag von Intelligenztests wurde lange überschätzt. Während Schmidt und Hunter (1998) davon ausgingen, dass ein Intelligenztest 25 % (r = .51) der Varianz im Berufserfolg vorhersagen kann, zeigte sich in der Studie von Sackett et al. (2021), dass nur 9 % (r = .31) des Erfolgs tatsächlich auf Intelligenz zurückzuführen sind. Dies deutet darauf hin, dass die Vorhersagekraft von Intelligenztests seit Jahren überschätzt wurde.

- Strukturierte Interviews sind entscheidend: Ein weiterer bedeutender Unterschied zeigt sich bei Interviews. Schmidt und Hunter (1998) fanden eine Validität von r = .51 für strukturierte und r = .38 für unstrukturierte Interviews. Sackett et al. (2021) hingegen berichten eine Validität von r = .42 bzw. r = .19. Dies unterstreicht, dass der Grad der Strukturierung eines Interviews erhebliche Auswirkungen auf seine Vorhersagekraft hat. Obwohl unstrukturierte Interviews Freiräume und Vorteile wie Natürlichkeit und soziale Akzeptanz bieten, führen strukturierte Interviews zu einer höheren Vorhersagekraft.

- Methodenkombinationen erhöhen die Validität: Sackett et al. (2021) betonen die Bedeutung der Kombination mehrerer Methoden. Um Diskriminierung zu vermeiden und eine faire Personalauswahl zu gewährleisten, ist es ratsam, verschiedene Instrumente zu kombinieren. Drei der „Top Five“-Prädiktoren für Berufserfolg aus der Studie von Sackett et al. (2021) zeigen erhebliche Unterschiede zwischen „schwarzen und weißen“ Probanden, was das Risiko ethnischer Diskriminierung erhöht. Eine methodische Kombination kann die Limitationen einzelner Verfahren ausgleichen und die Validität der Entscheidungsfindung verbessern.

Hierbei bieten sich insbesondere Assessment Center an, die eine solche Kombination von Auswahlverfahren beinhalten und Kandidat*innen anhand ihrer Kompetenzen in verschiedenen Übungen bewerten. Applysia unterstützt bei der Planung, Durchführung und Auswertung von Assessment Centern. Mit unserer digitalen Software werden Prozesse vereinfacht und personalisiert, Daten intuitiv und valide erhoben sowie fair ausgewertet. Weitere Informationen zu digitalen Assessments finden Sie unter www.applysia.de.